公司动态

出乎意料的是,最开放的新模型来自Xiaohongshu

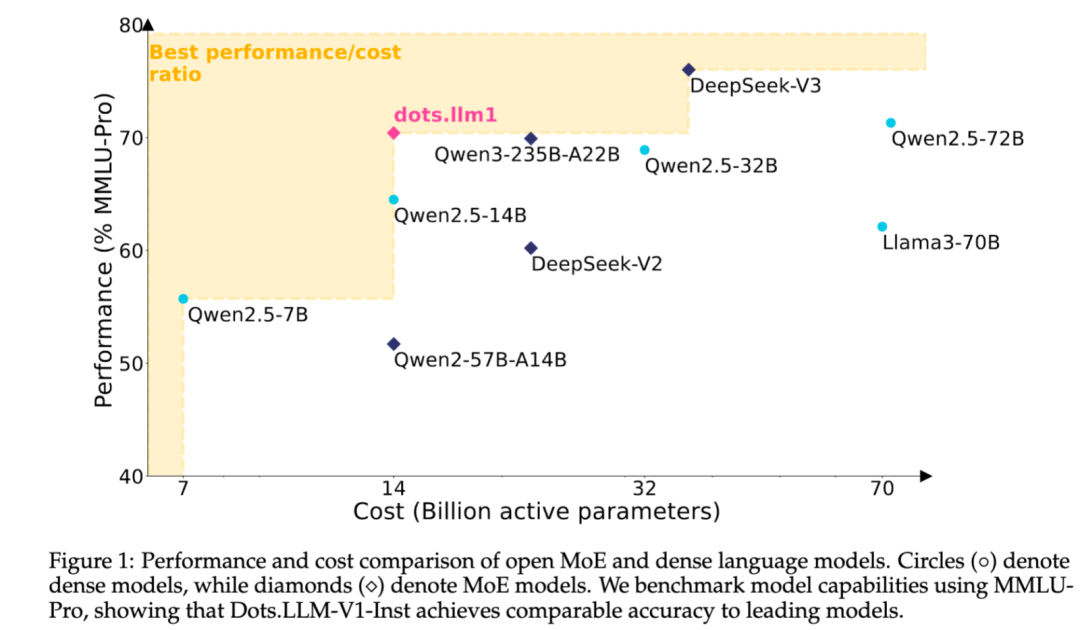

机器中心的编辑报告:Yang Wen到今天是该行业中最大的开放资源力量。米旺舒(Siaohongshu)在大型型号的钥匙中总是很低,他已经开设了昨天开发的第一个大型车型。该模型称为dot.llm1,以及由小舒·hi Lab(Humane Intelligence Lab)团队开发的文本模型。它的参数不是最大的,其中142B参数和14B激活参数。这是MOE大小的中型(专家组合)模型,但仍显示出较小的激活能力的性能。具体而言,在激活14b参数时,模型点5-72b-构造。同时,与QWEN3-32B相比,它的性能类似于中文,英语,数学和对齐活动。此外,该模型的开放资源强度在行业的上限中被称为“数量”。 HI Lab团队还认为,不仅是DOTS.LM1.IST模型开放给开发人员,还认为在假装的第一阶段以及两次模型的相应检查点模型和相应的检查点模型和长时间的基础以及一段时间的时间内,一系列的预处理基本模型以及一个在1T令牌之后保存的检查点。为了促进每个人进行持续的假装并正确管理维修,HI Lab团队还介绍了详细信息,例如LR计划和批处理大小。从头到尾,几乎每个细节都可以使用“第二创建”。自2023年以来,小苏开始投资于研究和开发的主要模型,而该开源是积极参与社区社区社区的重要一步。模型地址:https://huggingface.co/rednote-hilab https://github.com/rednote-hilab/dots.llm1如果第一手实际测试模型易于使用,则还取决于多维任务的实际测试性能。接下来,我们将将Xiaohongshu点模型带到“测验室”和CondUCT围绕问答,写作,编码等进行了全面的评估。让我们首先尝试理解中文的能力:最大的叔叔去了第二个叔叔的家找到第三叔叔,并说第四叔叔的叔叔被五叔叔的叔叔欺骗,偷走了皮顿叔叔,并把它放在第一位叔叔。第九叔叔借给第十叔叔的薪水。谁是小偷?这个问题就像是舌头的扭曲,但点并不困惑。它通过逐渐约会和评估句子结构,并最终正确地提供了“盗窃”行动的实施。 Smart Bar以幽默和荒谬的笑话而闻名。由于大型模型已经流行,因此“智能栏”已成为消除理解大型模型能力的标准之一。例如,这个经典的问题:教室也称为监狱牢房,为什么在您上班时不称其为监狱呢?点首先根据历史提供了严重的答案语言的进化和两者之间的差异,然后表现出模因,甚至连接表情符号。不仅如此,DOTS还了解奇怪的同音词。让我们看一下编写圆点文本的能力。它写了一首隐藏的诗《我今天要工作》,这是“活着的”,并使用一组清晨的照片来描述“工人”的疲劳,这是脚踏实地的。此外,它具有很大的感官线,因此我们要求创建一个使用HTML,CSS和JavaScript实施的响应式城市卡片组件。收到任务后,点不用说单词来发布代码。重要的是要说的是,它制作的动态卡的颜色非常舒适,并收集了各种元素,例如城市,日期,天气,温度,湿度和风速。单击右下角的thebutton也可以正确移动城市。技术解释:“大萌架构”下的“小测试”是FIdot.llm1的首次开源是小舒·舒·hi实验室的MOE模型,并不会盲目地追求“大力做奇迹”,而是通过更清洁,更好的数据,更好的数据,更好的数据,更好的数据,更好的数据和更好的数据和前提的前提和前端的前提和前端的前提和前提的前提和前提的前提和前提,从而实现了“小尝试”的影响。数据有限的培训资源。链接:https://github.com/rednote-hilab/dots.llm1/blob/main/dots1_tech_report.pdf预培训数据:您无需合成而“勉强强制”。在大型模型培训中,数据质量是决定模型上限的主要因素之一。 DOTS.LLM1使用11.2T高质量令牌数据进行预训练,这是由标准爬网和自己的蜘蛛获得的Web数据中的主要群体。与许多直接使用粗粒数据的开源模型不同,HI Lab团队非常“真的" in data processing, rejecting low-quality or fictitious content, and controlling data quality through three "processes": first, web document preparation, web html data is used to filter the web html data by url, and then Use the team's optimized trafilatura software package to extract the HTML text content, and finally language filtering and MD5 deduplication to obtain the document on the web. Next is the processing of the rule, which refers to the精制的网络和滤波者方案,用于清洁和过滤数据,这引入了Minhash和线路级的调整技术,以有效地过滤诸如AD和导航栏之类的嘈杂文本,最后使用模型处理,以确定网页,质量,在数据结构上的质量重复,并在许多模型中确定该过程,并准确地确定该文本的质量。上面,HI Lab团队获得了高质量预训练数据,并通过手动检查数据质量比Open TXT360数据源更好地证明。值得注意的是,dots.llm1不使用合成语料库,这也不能直接表明即使是大规模的数据合成也不取决于依赖,也可以训练足够强大的文本模型。但是,团队还说,数据综合作为改善差异-DATA和模型功能的一种方式,是值得探索未来的重要方向。卓越的实践:计算和交流非常平行。在MOE模型培训过程中,EP排名之间的A2A通信在当时的结局很大比例,这严重影响了培训效率。特别是对于细粒度的MOE模型,EP的大小相对较大,跨计算机通信通常是不可避免的。为了解决这一挑战,HI实验室与Nvidia China团队合作,提出了工程系列和创新性的建议LITENT:与A2A重叠的1F1B交织在一起。该解决方案的核心是尽可能地进行EP A2A通信,并使用计算来涵盖通信时间,从而提高训练效率。具体而言,他们可以通过在1F1B稳定阶段旋转1F1B稳定阶段的1f1b稳态阶段的1F1B反向1F1B的反向1F1B阶段的稳定阶段,即加热步骤 + 1。同时,HI Lab团队通过组合GEMM优化了HI Lab团队。他们将M_i(专家段I)与固定的块大小相一致。固定的块大小应为整数多个MMNNKK的整数MMNNKK,在异步WarpGroup级别矩阵乘法和添加(WGMMA,即WGMMA.MMA ASYNC)指令中。采用此设计,单个线路中的所有纱集都采用了一个瓷砖,而令牌(MI)处理的螺纹座的整个段都应在同一专家中,使其成为与普通Gemm操作中的调度过程相同。在实际试验之后,与NVIDIA变压器发动机中的GEMM API相比,HI LAB实施的操作员在远期计算中以6.68%的反向计算增加了14.00%。它充分证实了该解决方案的有效性和实际价值。模型和训练设计:WSD调度下的逐步优化在模型设计级别,DOTS.LLM1是基于解码器变压器的MOE模型。整体建筑设计在很大程度上捕捉了DeepSeek系列的思想和经验。在培训技术方面,该模型采用了WSD学习率计划的方法,整个培训过程主要分为两个阶段:稳定的培训和优化。在稳定的训练阶段,该模型保持了3E-4的研究率,并使用10T令牌语料库进行了训练。为了提高训练效率,在此阶段批次增加了两次,逐渐上升的Mula 64m至1.28m。整个训练过程是稳定的,没有需要退缩的尖峰。然后进入研究阶段,并在两个阶段进行1.2T令牌语料库进行训练。其中,阶段1期间的模型研究速率从3E-4的整合降低到3E-5,并且在数据中加强了知识语料库的认知和类型,并培训了总的1T令牌。在Stage2期间,模型研究率从3E-5退火降至1E-5,并且数据中的数学和代码语料库的比例得到了改善,总共培训了200B令牌。训练后:高质量,多幕科,结构化训练技术在完成高质量的预训练后,点dots.llm1额外的抛光剂通过管理和正确维修的两个阶段对模型的理解和实施。 Maingand筛选了HI Lab团队大约40万质量的教学数据,涵盖了五个主要情况,包括许多对话旋转,知识nd回答问题,复杂的教学随访,推理和发电代码。在许多对话周期中:团队将中文 - 英语对话数据与内部优质的中文对话数据结合在一起,并使用教师的模型来优化低质量的答案,以提高一般对话的连贯性和准确性;知识问题模块和答案:引入了一组包含事实知识和理解阅读的数据,以便模型可以更好地理解和回答不同的知识问题;复杂的教学合规性循环的一部分:团队特别取消了资格的指导数据,并伴随着障碍条件,以及不符合障碍的滤波器响应;数学和代码字段:验证器已验证精细维修数据,以确保获得最高的管理信号。正确修复的整个过程分为两个阶段:第一阶段是执行T在整个数据中进行了大量的基本培训,并最初引入了诸如过采样,动态研究率修复和多轮对话剪接等技术,以释放该模型的潜力;第二阶段的重点是“关键突破”。在需要更高理解能力的数学和代码等活动中,该团队采用了拒绝拍打微调(RFT)方法,并伴随着验证器来过滤器,例如高度信心,进一步改善模型信息性能。考试的最终结果也引起了人们的注意:即使激活了14b参数,dot.llm1.int仍然可以很好地了解中文和英语,数学,代码生成,对准和其他活动,并且能够与QWEN2.5-32B结构竞争,甚至QWEN2.5-72B结构。在比较更高级的QWEN3-32B时,dots.llm1.ins在许多任务中还显示出相似甚至更强的性能。浓在拥抱面的开源模型清单上,中国型号占据了一半的市场,开放资源逐渐成为大型中国模型团队的集体共识。 DOTS.LLM1的开放资源不仅显示了小舒H Teami实验室的技术成就,而且还展示了选择路线的“声明” - 与闭门造车后面的培训相比,他们更愿意进入世界并与专家交谈。在开发人员的眼中,这意味着模型的另一个值得信赖的基础。对于HI实验室,社区改进的结果也将返回主要模型,该模型注入了更多的模型可能性。

机器中心的编辑报告:Yang Wen到今天是该行业中最大的开放资源力量。米旺舒(Siaohongshu)在大型型号的钥匙中总是很低,他已经开设了昨天开发的第一个大型车型。该模型称为dot.llm1,以及由小舒·hi Lab(Humane Intelligence Lab)团队开发的文本模型。它的参数不是最大的,其中142B参数和14B激活参数。这是MOE大小的中型(专家组合)模型,但仍显示出较小的激活能力的性能。具体而言,在激活14b参数时,模型点5-72b-构造。同时,与QWEN3-32B相比,它的性能类似于中文,英语,数学和对齐活动。此外,该模型的开放资源强度在行业的上限中被称为“数量”。 HI Lab团队还认为,不仅是DOTS.LM1.IST模型开放给开发人员,还认为在假装的第一阶段以及两次模型的相应检查点模型和相应的检查点模型和长时间的基础以及一段时间的时间内,一系列的预处理基本模型以及一个在1T令牌之后保存的检查点。为了促进每个人进行持续的假装并正确管理维修,HI Lab团队还介绍了详细信息,例如LR计划和批处理大小。从头到尾,几乎每个细节都可以使用“第二创建”。自2023年以来,小苏开始投资于研究和开发的主要模型,而该开源是积极参与社区社区社区的重要一步。模型地址:https://huggingface.co/rednote-hilab https://github.com/rednote-hilab/dots.llm1如果第一手实际测试模型易于使用,则还取决于多维任务的实际测试性能。接下来,我们将将Xiaohongshu点模型带到“测验室”和CondUCT围绕问答,写作,编码等进行了全面的评估。让我们首先尝试理解中文的能力:最大的叔叔去了第二个叔叔的家找到第三叔叔,并说第四叔叔的叔叔被五叔叔的叔叔欺骗,偷走了皮顿叔叔,并把它放在第一位叔叔。第九叔叔借给第十叔叔的薪水。谁是小偷?这个问题就像是舌头的扭曲,但点并不困惑。它通过逐渐约会和评估句子结构,并最终正确地提供了“盗窃”行动的实施。 Smart Bar以幽默和荒谬的笑话而闻名。由于大型模型已经流行,因此“智能栏”已成为消除理解大型模型能力的标准之一。例如,这个经典的问题:教室也称为监狱牢房,为什么在您上班时不称其为监狱呢?点首先根据历史提供了严重的答案语言的进化和两者之间的差异,然后表现出模因,甚至连接表情符号。不仅如此,DOTS还了解奇怪的同音词。让我们看一下编写圆点文本的能力。它写了一首隐藏的诗《我今天要工作》,这是“活着的”,并使用一组清晨的照片来描述“工人”的疲劳,这是脚踏实地的。此外,它具有很大的感官线,因此我们要求创建一个使用HTML,CSS和JavaScript实施的响应式城市卡片组件。收到任务后,点不用说单词来发布代码。重要的是要说的是,它制作的动态卡的颜色非常舒适,并收集了各种元素,例如城市,日期,天气,温度,湿度和风速。单击右下角的thebutton也可以正确移动城市。技术解释:“大萌架构”下的“小测试”是FIdot.llm1的首次开源是小舒·舒·hi实验室的MOE模型,并不会盲目地追求“大力做奇迹”,而是通过更清洁,更好的数据,更好的数据,更好的数据,更好的数据,更好的数据和更好的数据和前提的前提和前端的前提和前端的前提和前提的前提和前提的前提和前提,从而实现了“小尝试”的影响。数据有限的培训资源。链接:https://github.com/rednote-hilab/dots.llm1/blob/main/dots1_tech_report.pdf预培训数据:您无需合成而“勉强强制”。在大型模型培训中,数据质量是决定模型上限的主要因素之一。 DOTS.LLM1使用11.2T高质量令牌数据进行预训练,这是由标准爬网和自己的蜘蛛获得的Web数据中的主要群体。与许多直接使用粗粒数据的开源模型不同,HI Lab团队非常“真的" in data processing, rejecting low-quality or fictitious content, and controlling data quality through three "processes": first, web document preparation, web html data is used to filter the web html data by url, and then Use the team's optimized trafilatura software package to extract the HTML text content, and finally language filtering and MD5 deduplication to obtain the document on the web. Next is the processing of the rule, which refers to the精制的网络和滤波者方案,用于清洁和过滤数据,这引入了Minhash和线路级的调整技术,以有效地过滤诸如AD和导航栏之类的嘈杂文本,最后使用模型处理,以确定网页,质量,在数据结构上的质量重复,并在许多模型中确定该过程,并准确地确定该文本的质量。上面,HI Lab团队获得了高质量预训练数据,并通过手动检查数据质量比Open TXT360数据源更好地证明。值得注意的是,dots.llm1不使用合成语料库,这也不能直接表明即使是大规模的数据合成也不取决于依赖,也可以训练足够强大的文本模型。但是,团队还说,数据综合作为改善差异-DATA和模型功能的一种方式,是值得探索未来的重要方向。卓越的实践:计算和交流非常平行。在MOE模型培训过程中,EP排名之间的A2A通信在当时的结局很大比例,这严重影响了培训效率。特别是对于细粒度的MOE模型,EP的大小相对较大,跨计算机通信通常是不可避免的。为了解决这一挑战,HI实验室与Nvidia China团队合作,提出了工程系列和创新性的建议LITENT:与A2A重叠的1F1B交织在一起。该解决方案的核心是尽可能地进行EP A2A通信,并使用计算来涵盖通信时间,从而提高训练效率。具体而言,他们可以通过在1F1B稳定阶段旋转1F1B稳定阶段的1f1b稳态阶段的1F1B反向1F1B的反向1F1B阶段的稳定阶段,即加热步骤 + 1。同时,HI Lab团队通过组合GEMM优化了HI Lab团队。他们将M_i(专家段I)与固定的块大小相一致。固定的块大小应为整数多个MMNNKK的整数MMNNKK,在异步WarpGroup级别矩阵乘法和添加(WGMMA,即WGMMA.MMA ASYNC)指令中。采用此设计,单个线路中的所有纱集都采用了一个瓷砖,而令牌(MI)处理的螺纹座的整个段都应在同一专家中,使其成为与普通Gemm操作中的调度过程相同。在实际试验之后,与NVIDIA变压器发动机中的GEMM API相比,HI LAB实施的操作员在远期计算中以6.68%的反向计算增加了14.00%。它充分证实了该解决方案的有效性和实际价值。模型和训练设计:WSD调度下的逐步优化在模型设计级别,DOTS.LLM1是基于解码器变压器的MOE模型。整体建筑设计在很大程度上捕捉了DeepSeek系列的思想和经验。在培训技术方面,该模型采用了WSD学习率计划的方法,整个培训过程主要分为两个阶段:稳定的培训和优化。在稳定的训练阶段,该模型保持了3E-4的研究率,并使用10T令牌语料库进行了训练。为了提高训练效率,在此阶段批次增加了两次,逐渐上升的Mula 64m至1.28m。整个训练过程是稳定的,没有需要退缩的尖峰。然后进入研究阶段,并在两个阶段进行1.2T令牌语料库进行训练。其中,阶段1期间的模型研究速率从3E-4的整合降低到3E-5,并且在数据中加强了知识语料库的认知和类型,并培训了总的1T令牌。在Stage2期间,模型研究率从3E-5退火降至1E-5,并且数据中的数学和代码语料库的比例得到了改善,总共培训了200B令牌。训练后:高质量,多幕科,结构化训练技术在完成高质量的预训练后,点dots.llm1额外的抛光剂通过管理和正确维修的两个阶段对模型的理解和实施。 Maingand筛选了HI Lab团队大约40万质量的教学数据,涵盖了五个主要情况,包括许多对话旋转,知识nd回答问题,复杂的教学随访,推理和发电代码。在许多对话周期中:团队将中文 - 英语对话数据与内部优质的中文对话数据结合在一起,并使用教师的模型来优化低质量的答案,以提高一般对话的连贯性和准确性;知识问题模块和答案:引入了一组包含事实知识和理解阅读的数据,以便模型可以更好地理解和回答不同的知识问题;复杂的教学合规性循环的一部分:团队特别取消了资格的指导数据,并伴随着障碍条件,以及不符合障碍的滤波器响应;数学和代码字段:验证器已验证精细维修数据,以确保获得最高的管理信号。正确修复的整个过程分为两个阶段:第一阶段是执行T在整个数据中进行了大量的基本培训,并最初引入了诸如过采样,动态研究率修复和多轮对话剪接等技术,以释放该模型的潜力;第二阶段的重点是“关键突破”。在需要更高理解能力的数学和代码等活动中,该团队采用了拒绝拍打微调(RFT)方法,并伴随着验证器来过滤器,例如高度信心,进一步改善模型信息性能。考试的最终结果也引起了人们的注意:即使激活了14b参数,dot.llm1.int仍然可以很好地了解中文和英语,数学,代码生成,对准和其他活动,并且能够与QWEN2.5-32B结构竞争,甚至QWEN2.5-72B结构。在比较更高级的QWEN3-32B时,dots.llm1.ins在许多任务中还显示出相似甚至更强的性能。浓在拥抱面的开源模型清单上,中国型号占据了一半的市场,开放资源逐渐成为大型中国模型团队的集体共识。 DOTS.LLM1的开放资源不仅显示了小舒H Teami实验室的技术成就,而且还展示了选择路线的“声明” - 与闭门造车后面的培训相比,他们更愿意进入世界并与专家交谈。在开发人员的眼中,这意味着模型的另一个值得信赖的基础。对于HI实验室,社区改进的结果也将返回主要模型,该模型注入了更多的模型可能性。 上一篇:热门搜索大学入口!这个男孩是第一个走出考试 下一篇:没有了